今年の8月に発表されてからローカルでやってみたいなーってふつふつ思っていました

RTX3070 8GBでちょっと厳しいか?設定どれくらいさげてしまうのか

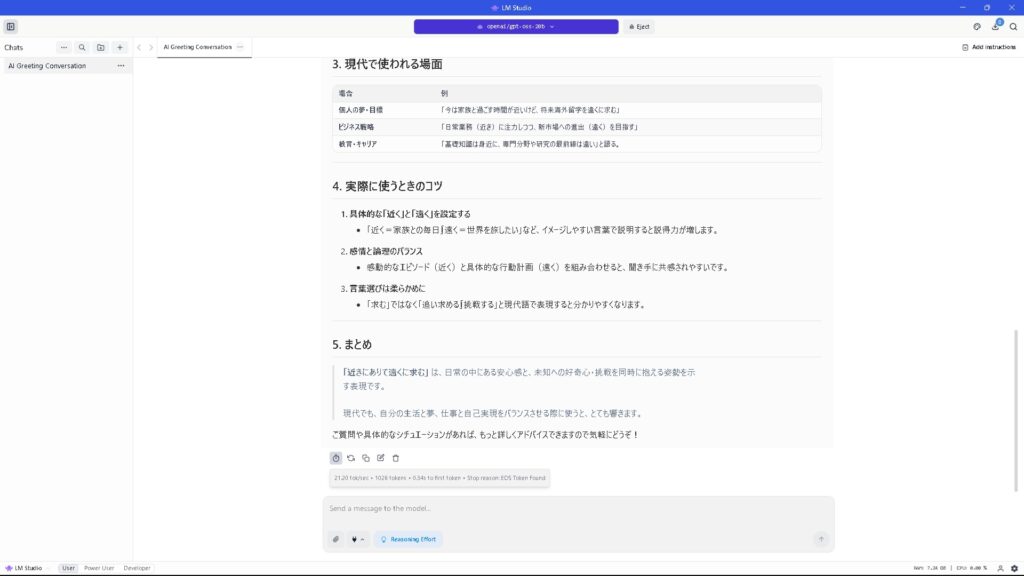

というわけで簡単にパラメーターを調整してみて、GPT-oss 20Bの精度なりもお触り程度に

使った管理ソフト?はLM Studio

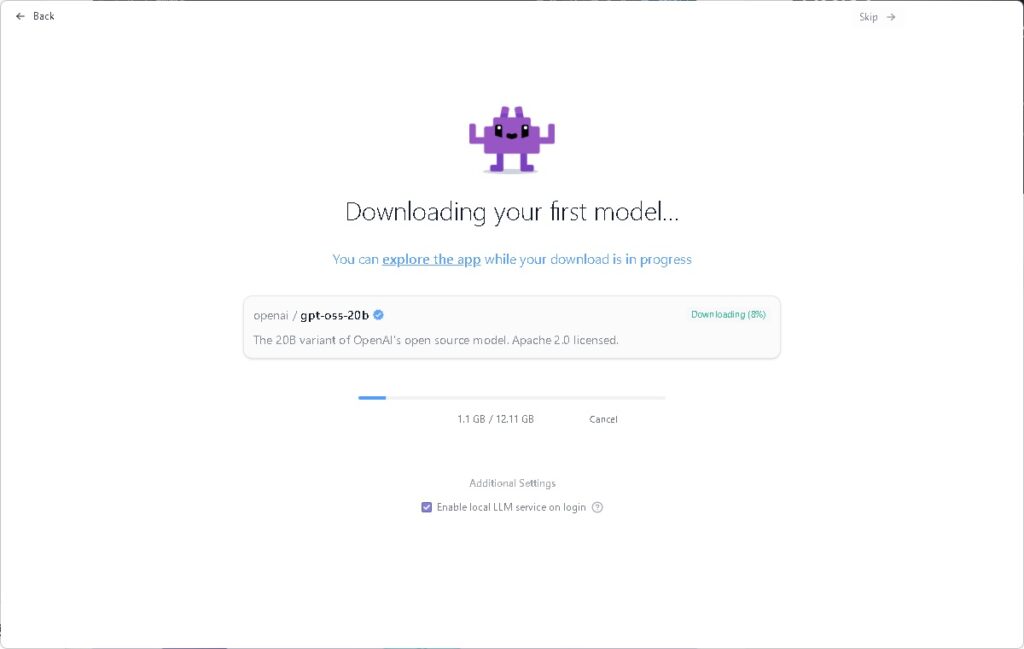

進めていくとGPT-oss 20Bがダウンロード候補になってるのでDLしてインストールしていく

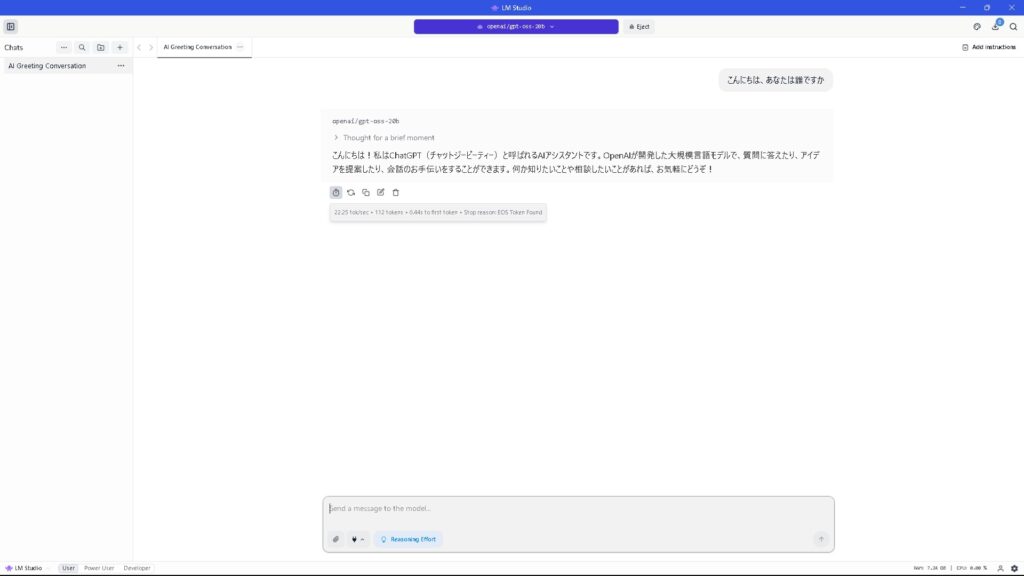

これで上の紺色のところでgpt-oss 20bを選択して読み込ませると完成!拍子抜けするくらいに簡単に自分専用ローカルAIができました

感謝です

Tokenも20/sなのでまぁまぁです

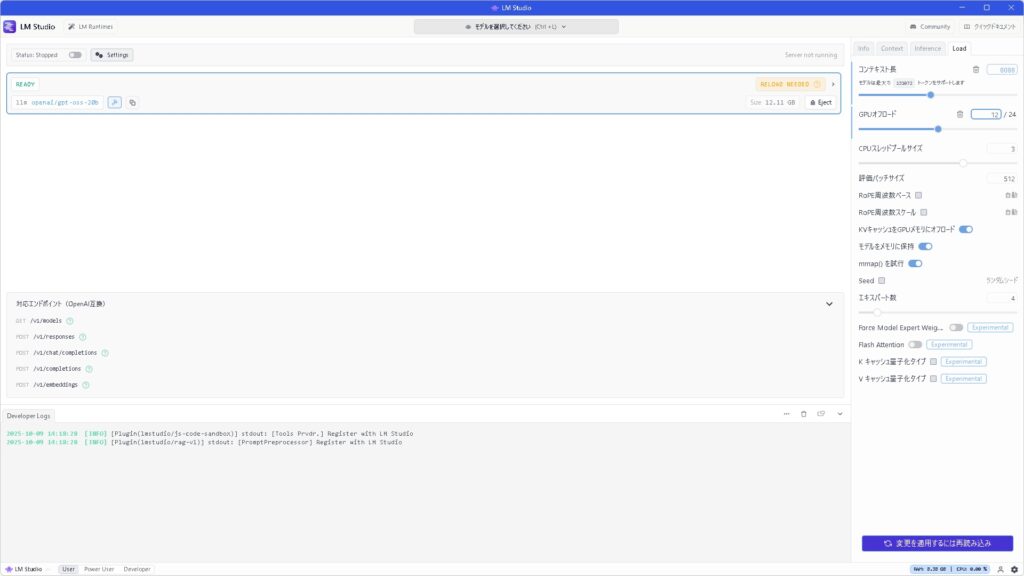

出力してくれる文字数が4000が標準なので、ちょっと長めの内容を語りだすとすぐに圧迫されるので8000程度にしてみます

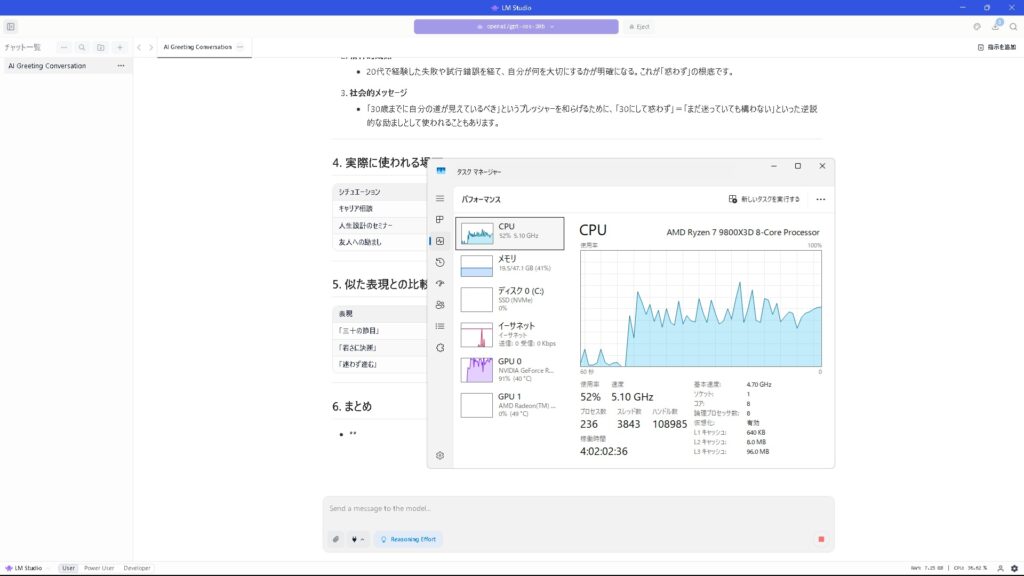

9800x3dではそこまでCPU負荷もいかない、というかGPUが大事ですから当然っちゃ当然

GPUは100%近くに張り付きます

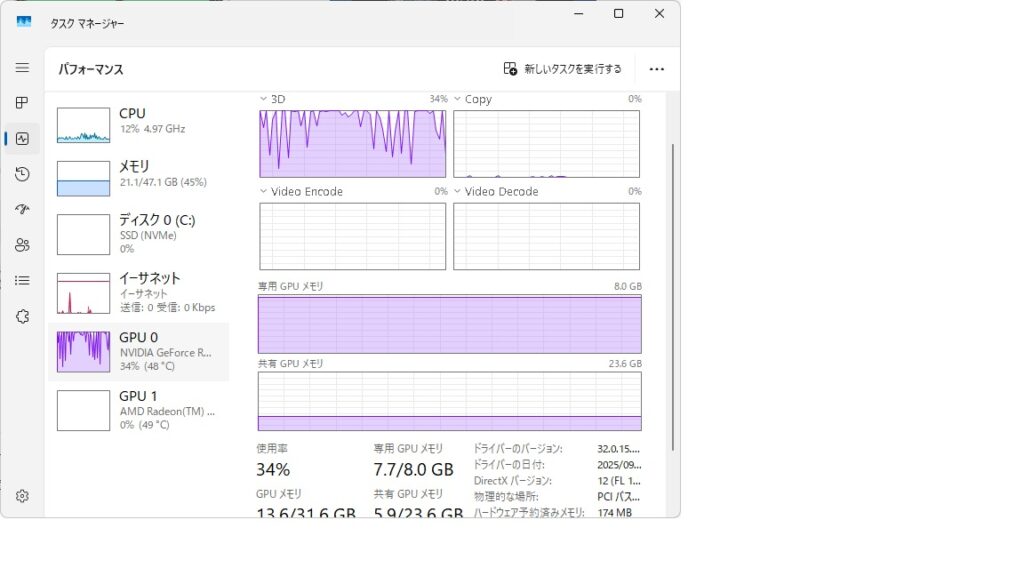

そして8GB VRAMに収まりきらなかったデータはメインメモリへ、6GBくらいお漏らし状態

と考えるとやはり、

8+6=14GB使っているわけで、16GBのVRAMのGPUは最低限必要になってきますね

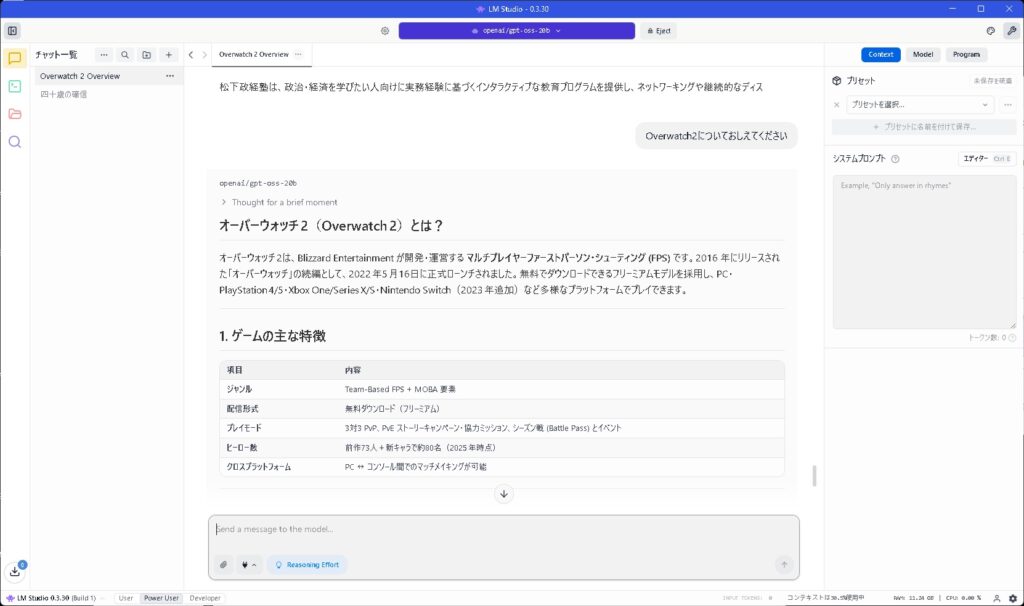

ハルシネーション(AIが嘘を生成する)もかなりあります

OverWatch2のヒーロー数に噴き出します

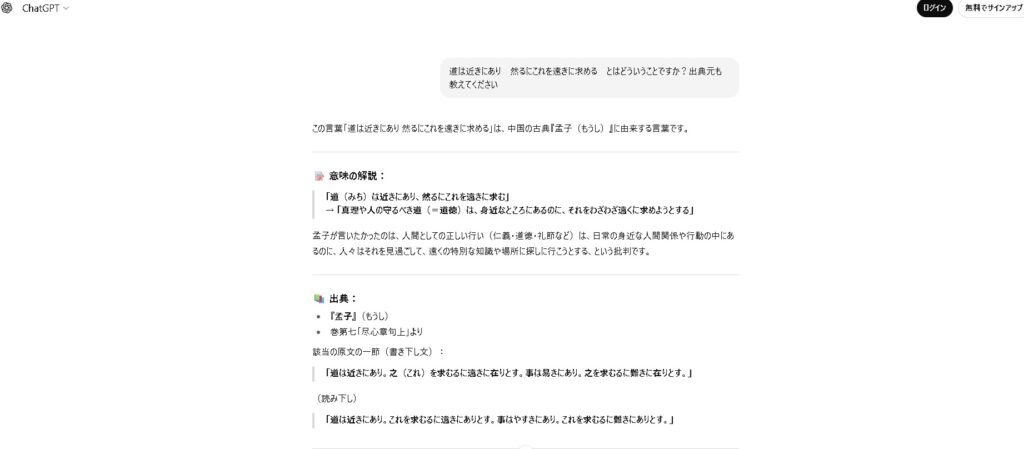

次は孟子の道は近きにありて~の意味と出典元を聞いてみます

1枚目がWebサービスのChatgpt(無料版)での質問

2枚目がgpt-oss 20Bでの質問

これに関しては20Bはちょっとひどすぎ

日本語を含む2Byte文字の変換読み取りが弱いモデルなのか?英語だと精度は上なんでしょうか

これだけ精度が怪しいとGPU投資するよりWebサービスのAIのほうが精度や実用面でいいかなと思ってしまいます

まぁOpenAIもビジネスなんで無償提供した古いモデルが実用的なら本業が割を食ってしまうから仕方ないと割り切る必要もあるでしょう

コメント